OpenStack の環境を構築します、といったときに皆さんどういう構成を思い浮かべるでしょうか。最近はドキュメントも充実してきているので、標準的なリファレンス構成を組むのであれば、情報には事欠かないかと思います。ですが実際には目的とする用途やコスト、運用モデルに合わせて様々考えられると思います。よいIaaS環境を構築できれば分散しているリソースを組織全体や外部へのサービスとして共有化、集約化することでスピードや生産性を高められます。そうしたOpenStackが持つメリットと組織の目的とをうまくソリューション化できればよいことはわかります。実際に北米を中心に、多くの企業がこれを取り込もうとしています。ではそのためのベストな構成とは何でしょうか。

(OpenStack Advent Calendar 2013 JPにエントリーして12/23分の記事として書いています。 https://github.com/irixjp/opstjp-ac/wiki/OpenStack-Advent-Calendar-2013-JP )

今現在のOpenStackのユースケースのわかりやすい例としては大手サービスプロバイダのIaaS環境があげられます。ですが今後拡大して行くであろうユースケースをOpenStackが提供して行くには何が必要か。おそらくこれを満たす単一の答えはないのだと思います。ただ一ついえるのは、ユーザ側に様々な選択肢が提供されていれば、課題は解決されて行くのだと思います。

では具体的に、OpenStack の検証環境を構成する最も簡単な方法の一つを紹介します。用意したものはOpenStack Havanaのベース環境として前回記事で紹介したVOVAのオールインワン構成と、nova-compute環境をそれを稼働させるハードウェア環境です:

- VOVA 0.2.1

- 仮想化環境: ESXi 5.5.0 (ベース、ネストとも)

- nova用環境: vCenter VM 5.5

- 設定用: Windows7 (vSphere Client)

- 物理サーバ1台, ネットワーク環境(この環境とOpenStackを利用するユーザの外部ネットワークの位置づけ)

前回記事で紹介したURLから、VOVAのOVAファイルをダウンロードしておきます。また、vCenterについても評価版などを使用して今回のベースESXi 5.5にデプロイして、データセンター、クラスタを構成しておきます。今回は下記のように構成しました。

- vCenter 5.5.0b

- VOVA用のESXi (ネスト)

- データセンター: VOVA_Testbed

- クラスタ: c1, c2 の2つ、それぞれ1つずつESXi(ネストしたもの)を接続しておく

基本的には上記の通りですが、ESXi用のネットワーク構成として管理用のネットワーク(VM Network)とOpenStack用のネットワーク(br100, VLAN100)をそれぞれ構成し、ESXiに仮想NICとして接続しておきます。

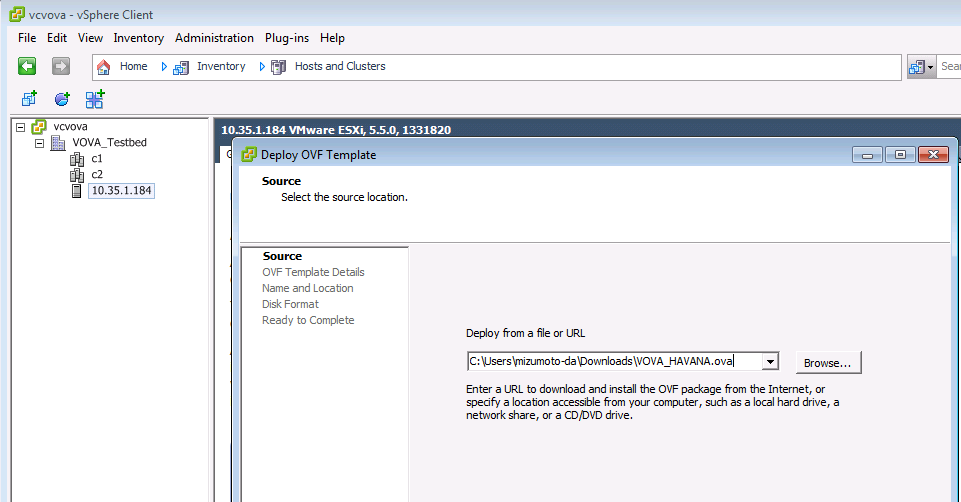

まず、VOVAのOVAファイルをデプロイします。vCenterにvSphereクライアントからログインし、ダウンロード済みのVOVAを選択します。

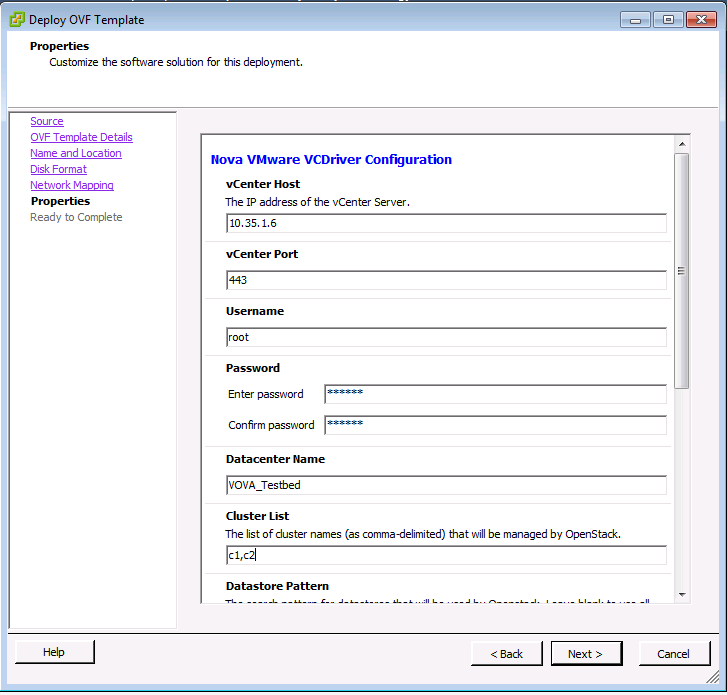

テンプレートに関連情報を入力します。これはOpenStackとvCenterを接続するための情報としてVOVAのVMをデプロイするときに自動的に設定されます。

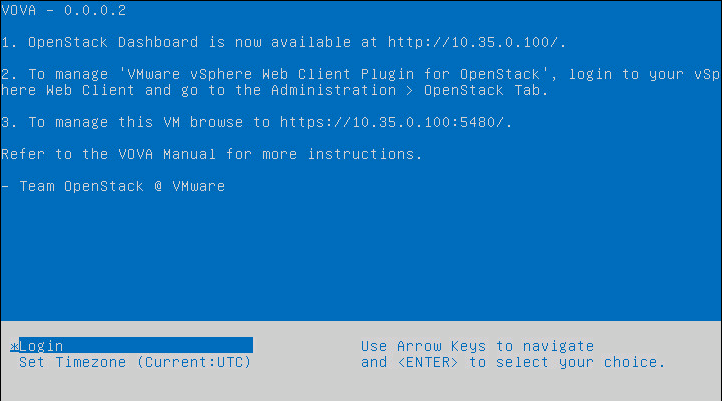

しばらくするとVOVAのデプロイが終わり、VOVA VMのコンソールに下記のようなメッセージが出力されます。この環境では外部接続用のネットワークにDHCPを使用しているため、自動的にOpenStack Dashboard用のIPも割り当てられています。

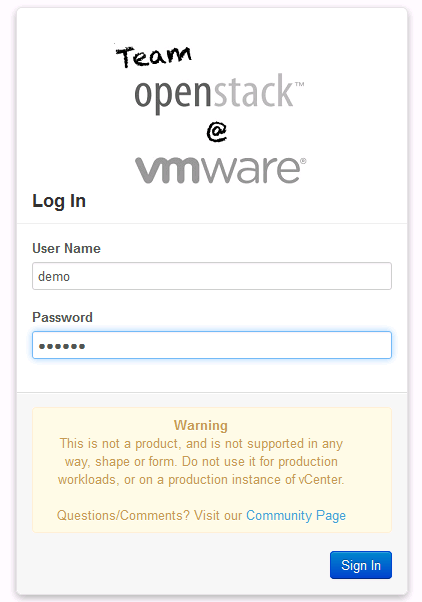

DashboardにWebブラウザで接続してみます。

demoユーザでログインできます。ここまででOpenStack + vCenter/vSphereのnova-compute環境の構成が完了しました。

この辺りの操作手順は公式のドキュメントにも記載されていますし、VMwareのハンズオンラボにもOpenStackの操作手順例が示されているので省略します。皆さんが普段目にされている手順とは全く異なるとは思いますが、非常に簡単にOpenStackの検証環境が用意できたのがおわかりいただけると思います。

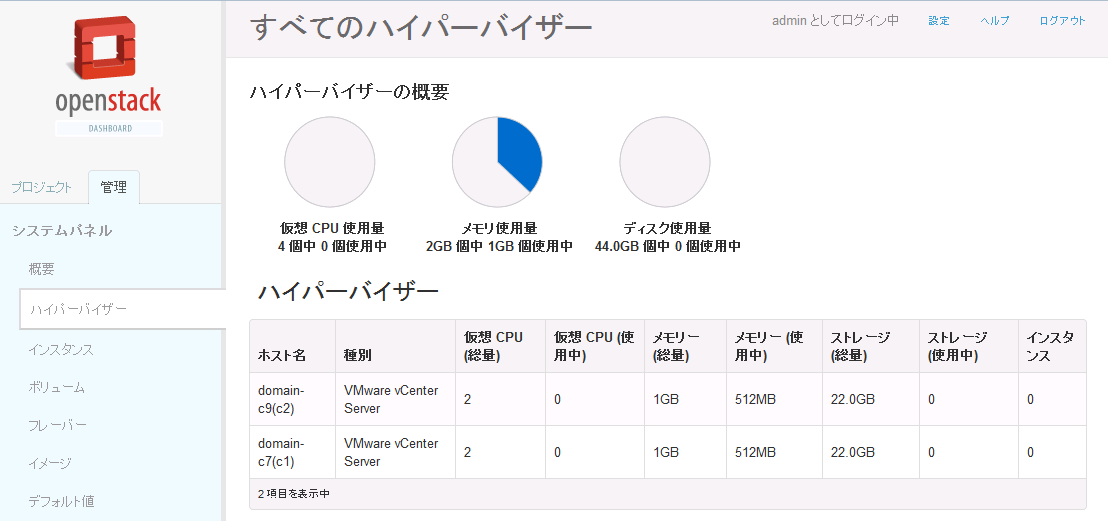

さらに、computeがどう構成されているかを見てみます。adminユーザで再度Dashboardにログインしてみます。

手順の前提で構成していたクラスタc1, c2がきちんと認識されているのが確認できますね。

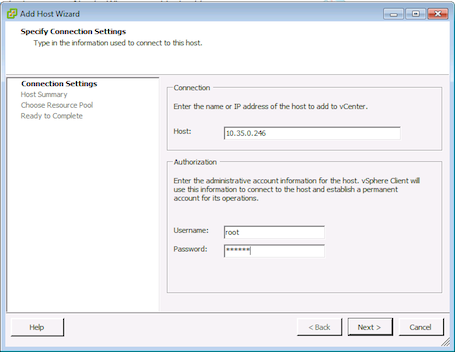

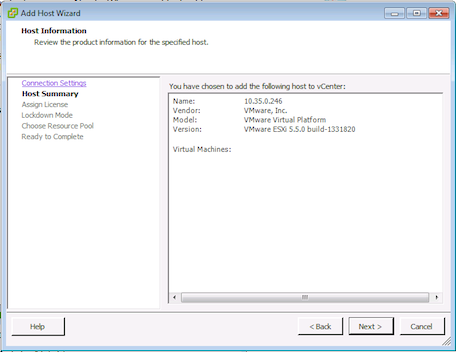

ここで、クラスタ(vCDriver経由のvCenter上のクラスタのコンピュートノード)へのホストの追加手順ですが、ESXiの初期設定を行ったホストを下記のようなウィザードで追加していました。

いかがでしょうか。今後OpenStackのユースケースがエンタープライズ用途に拡大して行けば、KVMや他のコンピュート用ドライバと並んでVMware環境を接続することのイメージはつかんでいただけたかと思います。

最後に上記環境のnova.confについて確認してみます。nova-compute用のドライバとしてVMwareVCDriverが指定されています。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 | |

参考: ここで紹介した以外にも、MacOSのFusion上でVOVAを動作させた有志もいるようです。こちらの場合は持ち歩けるOpenStackデモ環境になりますね。 http://virtualizedgeek.com/2013/12/22/installing-vmwares-openstack-virtual-appliance-in-vmware-fusion-techtalk-video/